資料內(nèi)容:

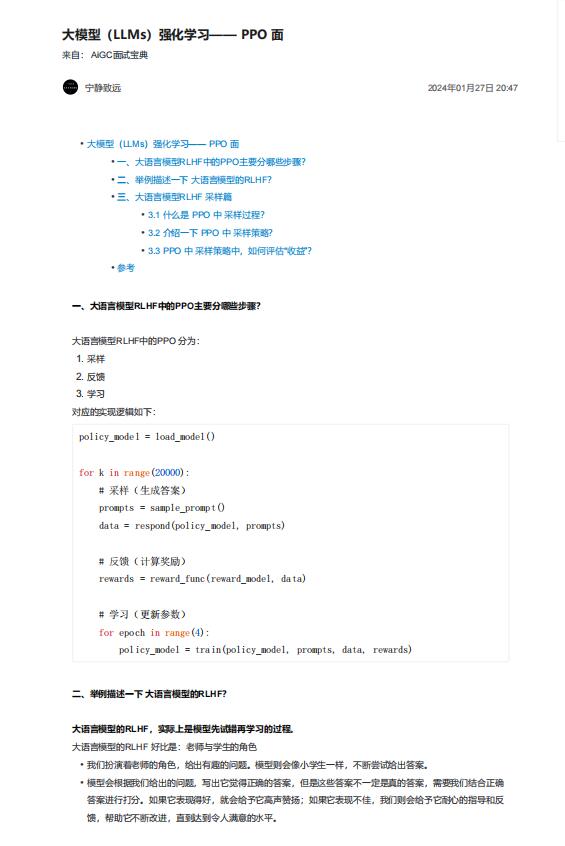

一、大語言模型RLHF中的PPO主要分哪些步驟?

大語言模型RLHF中的PPO 分為:

對應的實現(xiàn)邏輯如下:

二、舉例描述一下 大語言模型的RLHF?

大語言模型的RLHF,實際上是模型先試錯再學習的過程。

大語言模型的RLHF 好比是:老師與學生的角色

• 我們扮演著老師的角色,給出有趣的問題。模型則會像小學生一樣,不斷嘗試給出答案。

• 模型會根據(jù)我們給出的問題,寫出它覺得正確的答案,但是這些答案不一定是真的答案,需要我們結(jié)合正確

答案進行打分。如果它表現(xiàn)得好,就會給予它高聲贊揚;如果它表現(xiàn)不佳,我們則會給予它耐心的指導和反

饋,幫助它不斷改進,直到達到令人滿意的水平。